Article écrit par Sandra Schmidt Schmidt le 21/10/2019

EC et CAC : réfléchir à la manière d’adapter les processus à la data

La disruption de la profession est une véritable opportunité pour permettre aux experts-comptables et aux commissaires aux comptes de faire des travaux toujours plus intéressants. Cela passe par la recherche et développement et par les mémoires d’expertise comptable parfois très novateurs.

Il s’agit « d’enrichir le métier, de redéfinir le travail quotidien du professionnel pour un modèle plus collaboratif, plus soutenable et plus sociétal » précise Éléonore Caiveau-Partula, expert-comptable et commissaire aux comptes chez BDO.

Pour elle, l’expert-comptable et le commissaire aux comptes ont une vraie compétence, une vraie valeur ajoutée à apporter à leurs clients dans la gestion de la donnée et pas seulement de la donnée comptable.

Le parcours professionnel d’Éléonore Caiveau-Partula n’est pas celui du collaborateur de cabinet classique. Après une première expérience à la BPI en tant qu’analyste financier sur des opérations de garantie, de financement traditionnel et de haut de bilan avec des organismes de capital risque, elle rejoint alors un cabinet d’expertise comptable et d’audit en commençant à préparer le DSCG puis le DEC après un parcours classique classes préparatoires et école de commerce.

Entre les deux, elle travaillera dans plusieurs cabinets d’audit dont BDO et KPMG ce qui lui permettra d’intervenir sur des dossiers de tailles et de problématiques diverses, y compris des entreprises du CAC 40.

Elle terminera son diplôme d’expertise comptable avec un 19/20 au mémoire sur le thème de la démarche d’audit dans un contexte de Big Data.

« Une volonté permanente d’optimiser ses travaux, d’abord sous excel puis avec Power BI »

La donnée est de plus en plus importante pour les clients des experts-comptables et commissaires aux comptes. Elle n’est pourtant pas toujours totalement exploitée par les professionnels.

Pour Éléonore Caiveau-Partula, « les outils traditionnels qu’utilisent les commissaires aux comptes ne permettent pas systématiquement de traiter de manière optimale et exhaustive les données à auditer ». De plus, son expérience d’analyste financier lui donne un autre regard sur les données à exploiter qui ne sont pas que des données comptables mais aussi des données de gestion et extra financières.

Les dossiers importants qu’elle aura l’occasion de traiter l’obligeront à avoir une approche « d’audit par la data pour récupérer de la donnée exhaustive et l’exploiter aux travers d’analyses dynamiques ».

Excel d’abord puis Power BI lui permettront d’optimiser ses travaux.

Repenser les travaux de l’expert-comptable et du commissaire aux comptes autour de la donnée

« Gagner en pertinence et obtenir une meilleure connaissance de ses clients »

C’est un moyen de changer l’image du commissaire aux comptes et d’apporter toujours plus de valeur ajoutée dans les dossiers.

Les analyses multidimensionnelles facilitées par ces outils permettent un « enrichissement par des dimensions propres à l’activité du client ».

Dans le cadre d’une grande entreprise avec plusieurs branches d’activité qui ont chacune leurs caractéristiques propres, « les analyses peuvent être beaucoup plus fines et plus pertinentes avec une meilleure compréhension et sélection des populations à analyser puis à tester ».

L’objectif est d’aller beaucoup plus loin que « l’approche purement substantive sans se laisser porter uniquement par la méthodologie et challenger cette dernière par rapport aux spécificités du client ».

Sur les six années de mandat, « l’approche par la data permet de s’attaquer chaque année à des sujets différents, la donnée comptable la première année puis l’analyse du chiffre d’affaires et des stocks enrichis des données de gestion par exemple ».

Peut-on faire de l’approche par la data une priorité pour apporter plus de valeur à ses clients ?

« Le design des modèles de données en fonction de la typologie du client est un préalable à l’automatisation par l’intelligence artificielle »

L’étape préalable à la mise en place d’IA au sein des cabinets et une meilleure maitrise générale de la donnée par les commissaires aux comptes. En appréhendant mieux le système d’information de leurs clients et en mettant en place une approche orientée data, les commissaires aux comptes gagneront en assurance et identifieront de nouvelles opportunités de missions (gouvernance de la donnée, RGPD, etc…).

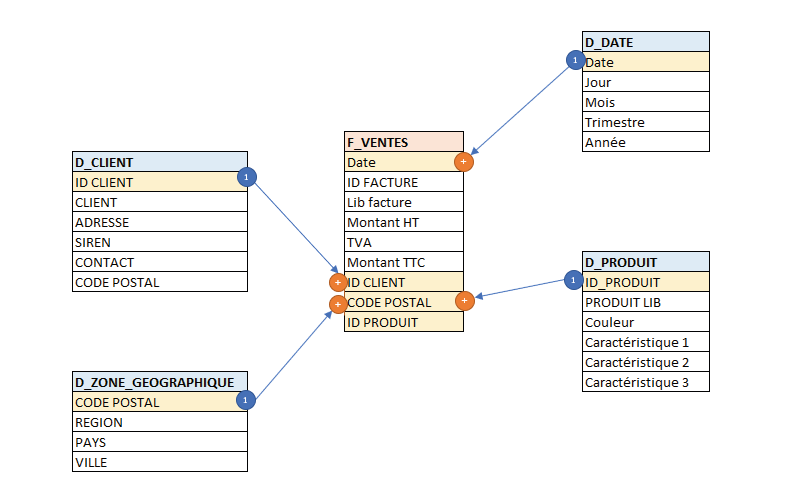

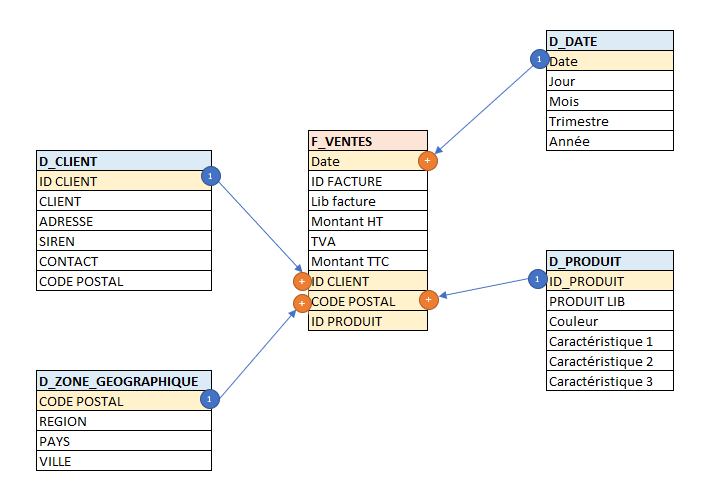

« En fonction de la typologie de client, le commissaire aux comptes est ainsi à même de monter des modèles de données qui lui permettent d’affiner ses analyses : par exemple analyse du chiffre d’affaires par client, par site, par catégorie produits, etc et ceci sur une même interface (i.e : Power BI). Au fur et à mesure que le commissaire aux comptes gagne en maîtrise avec ces outils il pourra penser efficacement des solutions de contrôle en continu, de robotisation, de data mining ou d’IA. Ce niveau de maturité qui est celui de la gestion de la donnée est donc un préalable indispensable ».

La donnée de base doit être de bonne qualité et les flux doivent être bien gérés en fonction des spécificités des différents métiers.

Avec Power BI ou un outil similaire, le commissaire aux comptes « n’est plus obligé de s’appuyer sur des reportings déjà prédéfinis sur lesquels il n’a pas la main ». L’utilisation d’excel est plus risqué et plus limitant. « Les outils de data modelisation et data visualisation permettent vraiment de libérer notre intelligence analytique en fiabilisant l’utilisation des données et permettant l’automatisation d’un certain nombre de traitements ».

« La culture de la DATA doit permettre au commissaire aux comptes de devenir un data expert »

On parle beaucoup de la culture data qui doit permettre à l’expert-comptable et au commissaire aux comptes de « devenir un expert des flux d’entreprise qui doit parvenir à obtenir une assurance sur la qualité des données qu’il exploite.

Les cabinets d’expertise comptable et d’audit ont « encore du chemin à parcourir. C’est un changement de paradigme, de façon de travailler, de processus au sein des cabinets ».

Les formations commencent tout juste à apparaître et il est « de plus en plus important, pour les cabinets de toutes les tailles, d’envisager de financer la recherche sur l’ensemble de ces sujets ».

En investissant sur ces nouvelles compétences et outils, de nouvelles opportunités sont offertes notamment au niveau services autres que la certification des comptes ou SACC. Du côté de l’expert-comptable, il est plus que possible « de repenser la mission d’expertise comptable pour qu’elle alimente le processus de mise en qualité de la donnée pour qu’en fin de chaîne, nous puissions mettre en place du controlling ou des reporting automatiques chez nos clients et commencer à réfléchir à la mise en place de robots pour optimiser certaines opérations » estime encore Eléonore Caiveau-Partula.

Les opportunités sont nombreuses pour les deux professions qui gagneront à s’en saisir pour faire évoluer leur métier.

L’expert-comptable et le commissaire aux comptes doivent acquérir la culture de la data et devenir des « data experts » à leur niveau

« Un mémoire d’expertise comptable qui permet de proposer une méthodologie »

Son mémoire d’expertise comptable lui permettra de se concentrer sur ce sujet qui la passionne et de monter encore en compétences.

La méthodologie proposée dans le cadre de son mémoire tenait compte de « l’extraction de la connaissance à partir de la donnée, des risques qui pèsent sur les données, de l’approche pour les appréhender, de l’appréhension de la démarche de manière pragmatique, de la manière de développer l’approche dans un cabinet et d’accompagner le changement ».

Avec des captures d’écran et une approche illustrée sur des procédures analytiques, elle expliquera comment les améliorer avec ces nouveaux outils.

Après un 4.1 obtenu du premier coup, sa soutenance se passera devant un jury intéressé par son mémoire, fruit de ces années de travail sur la data.

Son mémoire démontre qu’il reste encore beaucoup à faire sur ces sujets et que c’est une vraie opportunité pour les experts-comptables stagiaires mais aussi pour l’ensemble de la profession.